流式输出停止符的问题

BUG反馈

·

87 次浏览

回复内容

因为是内网环境搭建的,不太方便……

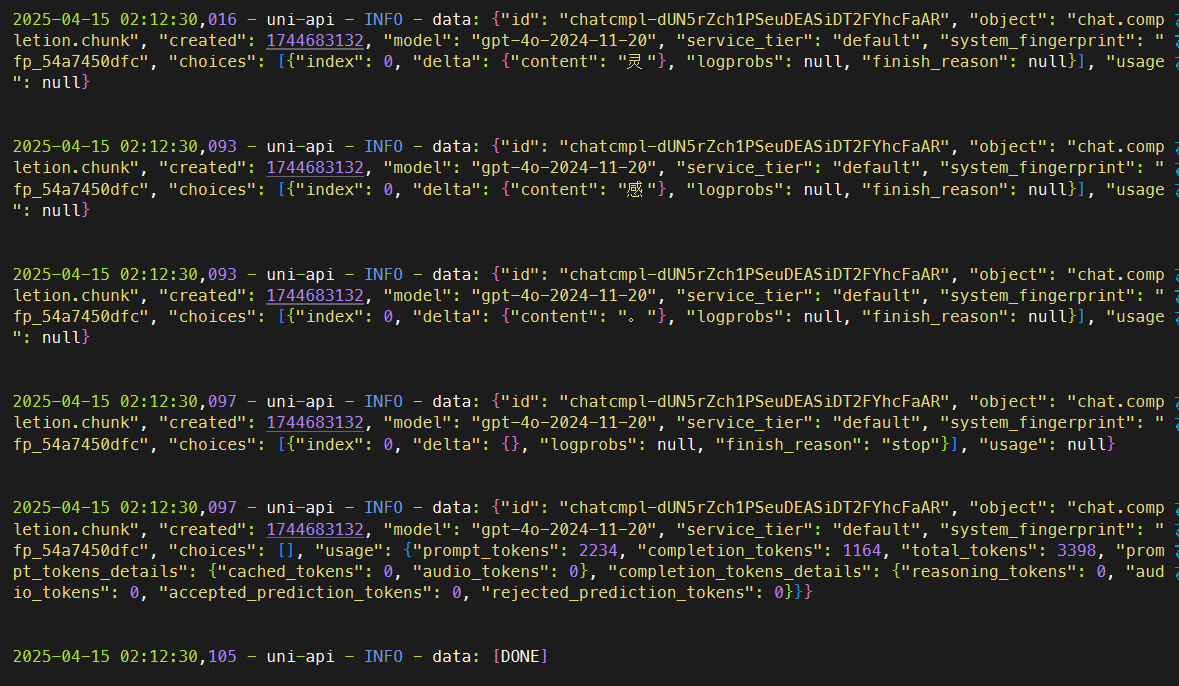

顺便忘记提了,测试时的模型用的是gpt-4o类型的,然后关闭流式输出后就不再出错了,然后再把最终文本输出到窗口其实也还行。

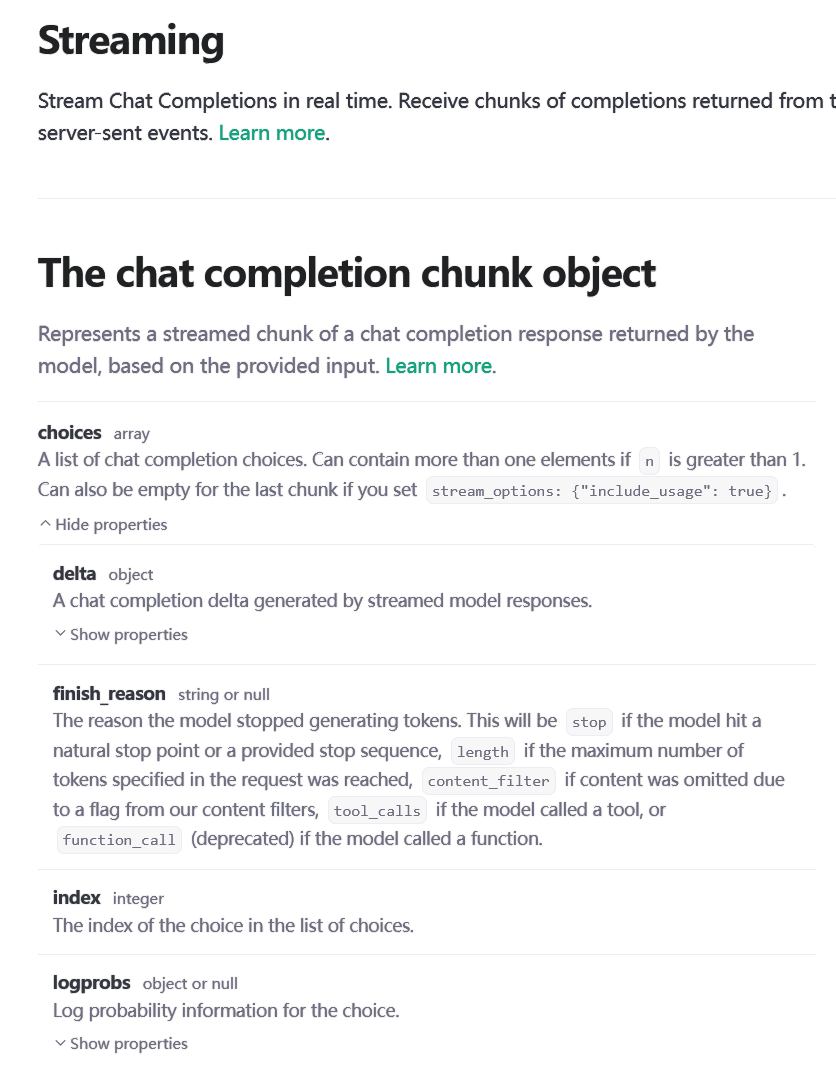

https://platform.openai.com/docs/api-reference/chat-streaming 这是openai的API文档,也确认了是通过 finish_reason 来控制停止生成token。

closeai 转发的gpt api 同样遇到这个报错,在别的兼容chat api的客户端均无问题

closeai我测试了一下,有一些消息会缺失choices数据,看起来中转不是直接转发原始需求的。我等加个判断一下。

https://getquicker.net/Help/Versions 试下最新版看看。

京公网安备 11010502053266号

京公网安备 11010502053266号